File

Edit

View

Help

Back

Veille informatique

Faire de la veille informatique est une pratique cruciale dans le paysage numérique moderne. Voici pourquoi

je considère cette activité comme indispensable :

-

Restez informé des menaces et des vulnérabilités :

Dans un monde où la cybersécurité est une préoccupation majeure, la veille informatique me permet de me

tenir au courant des dernières menaces et vulnérabilités informatiques. En surveillant les nouvelles

techniques d'attaque et les failles de sécurité, je peux prendre des mesures proactives pour protéger mes

données et mon infrastructure numérique.

-

Identifiez les meilleures pratiques et les solutions innovantes :

En suivant l'actualité de l'industrie et en consultant des sources fiables, je peux découvrir les

meilleures pratiques et les solutions innovantes qui peuvent améliorer l'efficacité de mes processus

informatiques. Cela peut inclure l'adoption de nouvelles technologies, l'automatisation des tâches

répétitives ou l'optimisation de l'architecture système.

-

Anticipez les évolutions du marché et les opportunités professionnelles :

En observant les tendances du marché et les mouvements de l'industrie, je suis mieux préparé à anticiper

les évolutions futures et les opportunités professionnelles qui en découlent. Cela peut m'aider à orienter

ma carrière dans la bonne direction et à saisir les occasions dès qu'elles se présentent.

-

Assurez une veille concurrentielle efficace :

En surveillant les activités de mes concurrents et en analysant leur stratégie numérique, je peux

obtenir des informations précieuses sur leur positionnement sur le marché, leurs forces et leurs

faiblesses. Cela me permet de prendre des décisions stratégiques éclairées pour rester compétitif et

innovant dans mon domaine.

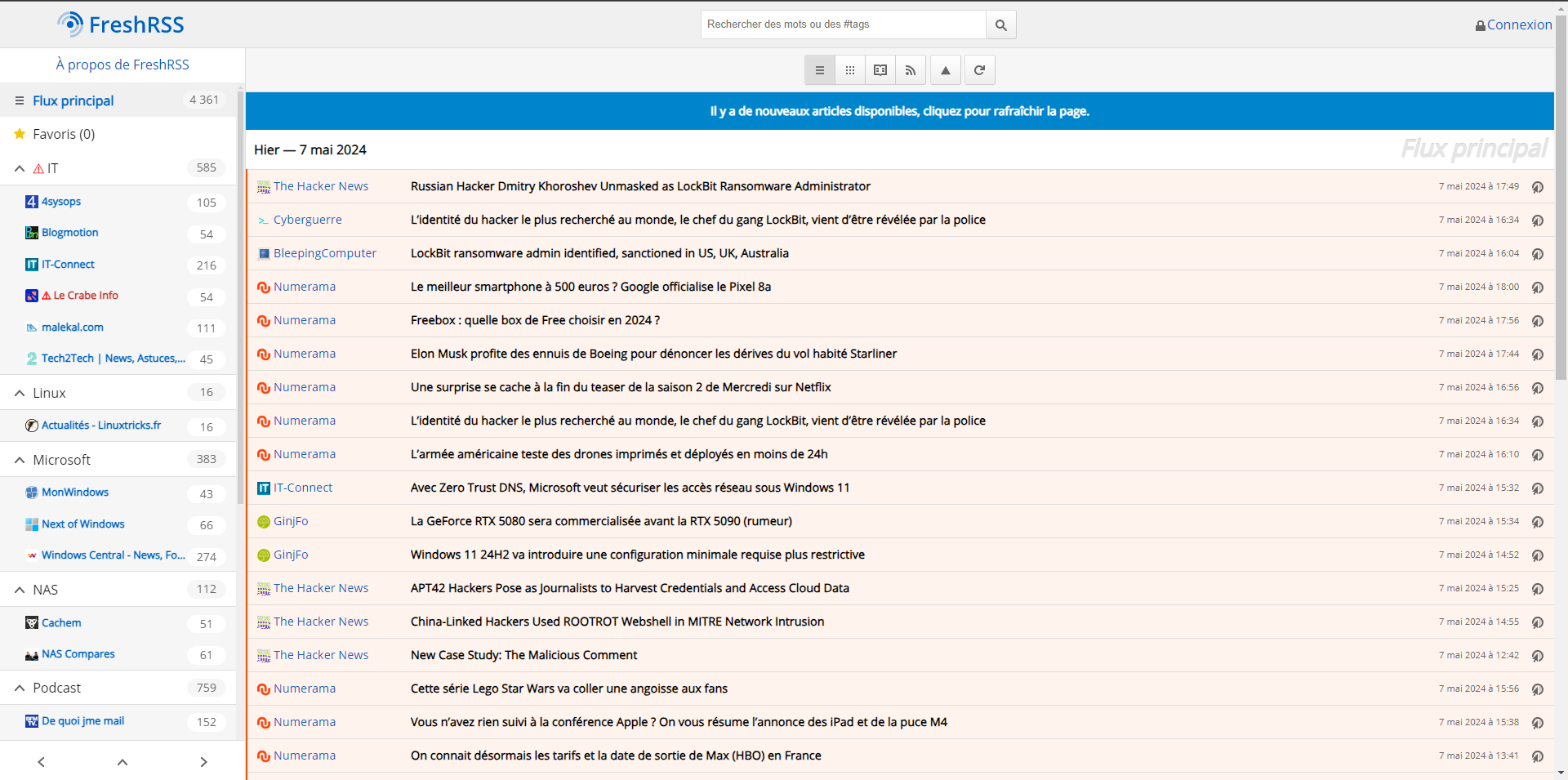

Récemment, j'ai découvert un site pour rester au courant des dernières actualités technologiques : Tech2Tech

. Ce site utilise une plateforme de gestion de flux RSS appelée FreshRSS, qui

présente une particularité de l‘auto-héberger.

En optant pour l'auto-hébergement de FreshRSS, on prend le contrôle total de sa propre expérience de veille

technologique. Plus besoin de dépendre d'une tierce partie pour accéder à ses flux RSS.

En conclusion, la veille informatique est un élément essentiel de ma stratégie professionnelle dans un

monde numérique en constante évolution. Cela me permet de rester compétent, de sécuriser mes systèmes,

d'identifier les opportunités et de prendre des décisions éclairées pour réussir dans mon domaine

d'activité.

Back

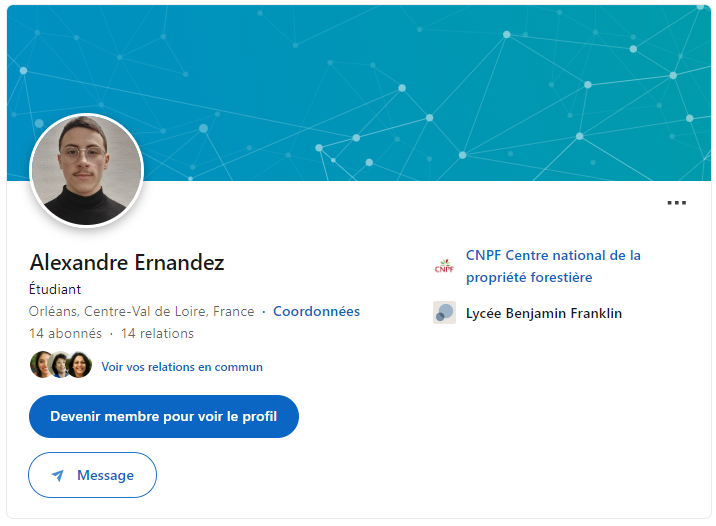

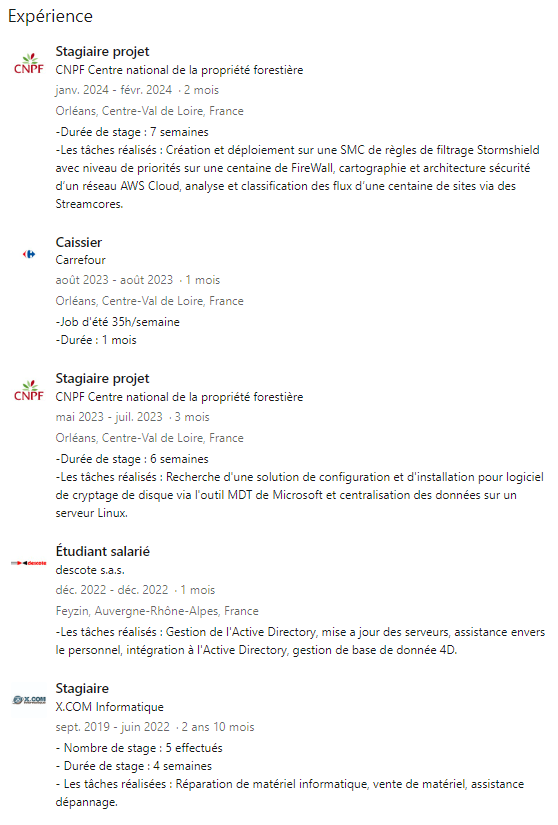

LinkedIn

Créer mon profil LinkedIn est une étape essentielle pour gérer mon identité professionnelle de manière

efficace. Voici pourquoi je considère cette démarche comme importante :

-

Visibilité professionnelle :

En créant mon profil, j'augmente ma visibilité auprès d'un vaste

réseau de

pairs, recruteurs, employeurs potentiels et collègues du secteur.

-

Réseau professionnel :

LinkedIn me permet de développer et de maintenir un réseau professionnel

solide.

Je peux me connecter avec des personnes travaillant dans mon domaine d'intérêt, échanger des idées,

obtenir des conseils et même trouver des mentors.

-

Recherche d'opportunités professionnelles :

De nombreuses entreprises utilisent LinkedIn pour

recruter

de nouveaux talents. En ayant un profil bien optimisé, j'augmente mes chances d'être repéré par des

recruteurs à la recherche de candidats ayant mes compétences et mon expérience.

-

Construction de ma marque personnelle :

Mon profil LinkedIn est une vitrine de mon parcours

professionnel, de mes compétences et de mes réalisations. En le personnalisant avec un résumé percutant,

des expériences pertinentes et des recommandations, je renforce ma marque personnelle et je me démarque de

la concurrence.

-

Veille professionnelle :

LinkedIn est une excellente source d'informations sur les tendances de

l'industrie, les nouvelles opportunités, les événements et les publications pertinentes. En suivant des

entreprises, des influenceurs et des groupes pertinents, je reste informé et à jour dans mon domaine.

En résumé, la création de mon profil LinkedIn est un investissement précieux dans mon identité

professionnelle. Cela me permet non seulement d'être visible et accessible aux opportunités

professionnelles, mais aussi de construire et de maintenir des relations professionnelles précieuses tout au

long de ma carrière.

Back

Wordpress GSB

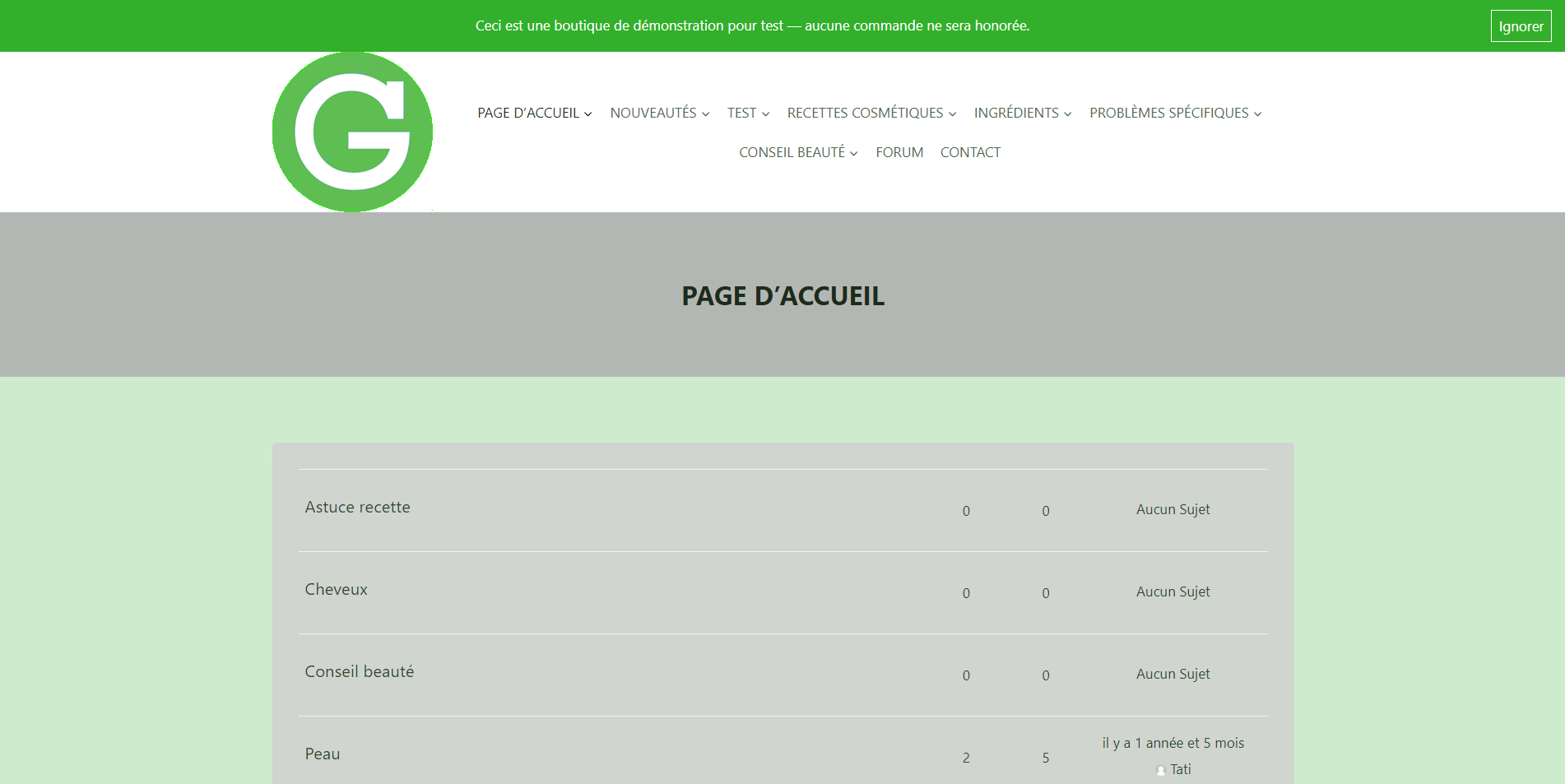

Au cours de ma première année de BTS, j'ai eu comme projet de groupe de réaliser un projet axé sur la

création d'un site Internet dédié à la promotion des alternatives naturelles en matière de produits

cosmétiques, ainsi qu'à la mise en avant des produits commercialisés par GSB Bio.

Ce projet s'inscrit dans le cadre d'une mission où j'ai été amené à mettre en œuvre mes compétences en

développement web, en utilisant un système de gestion de contenu ou SGC est un programme informatique

permettant de créer un site internet, la plateforme Wordpress était le SGC utilisé comme outil principal

pour le projet.

Pour mener à bien cette mission, j'ai suivi une méthodologie rigoureuse, basée sur des entretiens et des

tests visant à identifier les besoins des utilisateurs potentiels et à concevoir l'architecture du site.

L'objectif stratégique du site est clairement défini : il s'agit de fournir au grand public des informations

pertinentes sur les recettes et conseils cosmétiques naturels, ainsi que sur les ingrédients utilisés et

leurs propriétés bénéfiques.

Voici le cahier des charges qui m'a suivie lors de la réalisation de ce projet :

Cahier des charges projet

Le site web que j'ai développé présente une variété de contenus, comprenant des recettes, des descriptions

d'ingrédients, ainsi que des conseils et outils pour la fabrication de produits cosmétiques maison. De plus,

il sert de vitrine pour les produits cosmétiques commercialisés par GSB Bio, offrant ainsi une visibilité

accrue à cette entreprise spécialisée dans les produits naturels.

Dans une perspective d'évolution, le site a été conçu pour intégrer une phase ultérieure de

commercialisation en ligne des produits, prévoyant ainsi une expansion future de ses fonctionnalités.

Ce projet fut réalisé en suivant la méthode scrum avec la création d'un Trello qui détail les différentes

étapes de réalisations du projet.

Voici des images du site internet :

Back

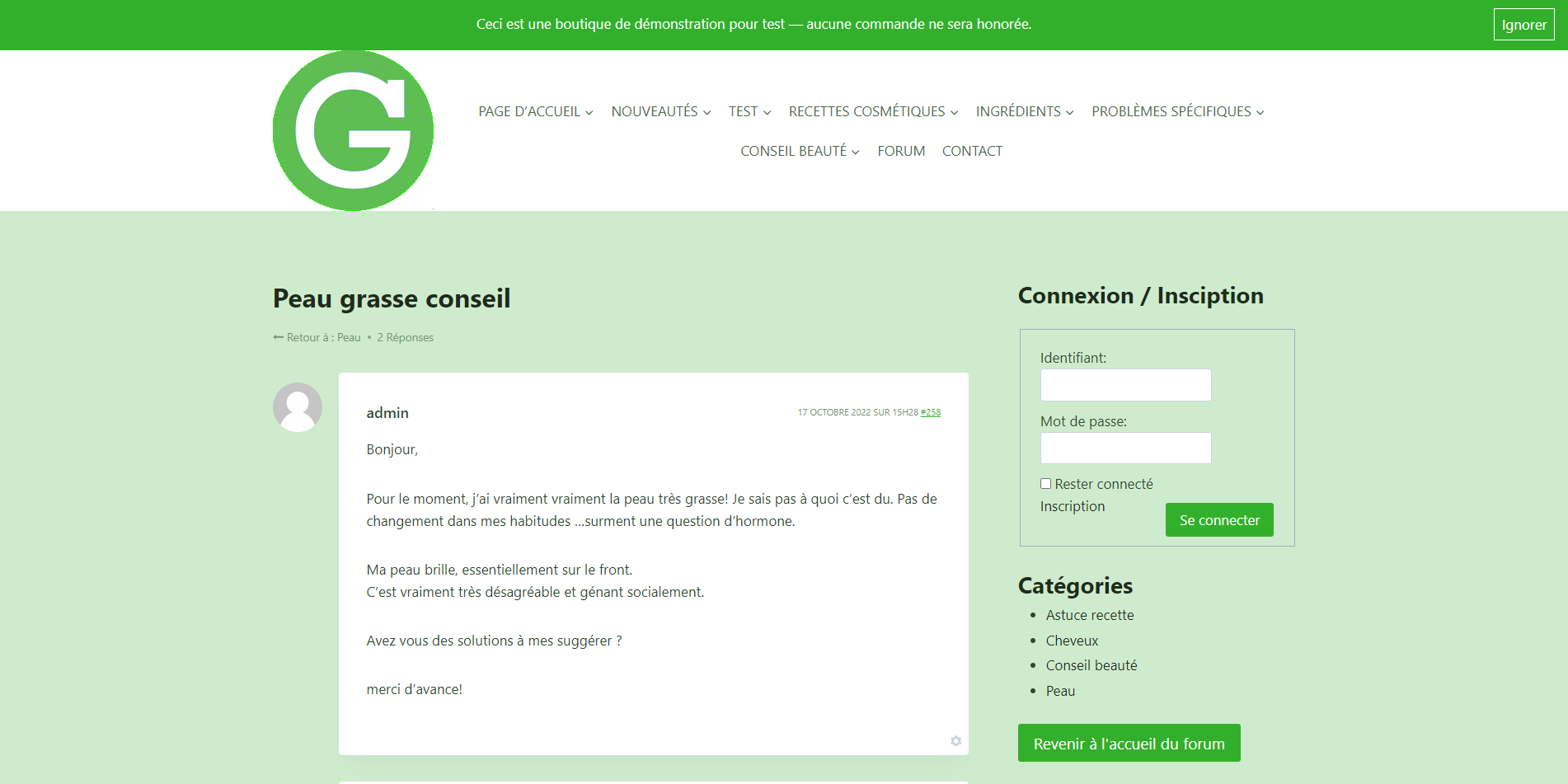

Mise en place de Keepalived dans la DMZ pour l'Entreprise GSB

Définition du Besoin

Le serveur outlab occupe une place centrale dans l'infrastructure web de l'entreprise GSB (Galaxy Swiss

Bourdin). Accessible via l'URL http://www.gsbX.com (où X correspond au numéro de laboratoire), ce serveur

hébergeant le service Apache2 est crucial pour plusieurs raisons :

- Il constitue la vitrine numérique de l'entreprise.

- Il stocke des documents importants tels que les comptes rendus de CA et les circulaires.

- Il centralise les comptes-rendus des visiteurs médicaux.

- Il présente les produits du laboratoire ainsi que les informations détaillées sur les praticiens.

- Il gère les frais de déplacement, de restauration et d'hébergement liés à l'activité de visite médicale.

Cependant, aux heures de pointe, notamment lors d'une forte affluence de consultations, les temps de

réponse du serveur outlab se dégradent considérablement. Il devient alors difficile pour les visiteurs

médicaux et les employés de l'entreprise d'accéder rapidement aux informations nécessaires. Il est impératif

que le service web reste accessible en tout temps, sans aucune interruption.

Contexte du Projet

Ce projet a été réalisé au cours de ma deuxième année d'étude dans le cadre de la mise en place d'une

infrastructure réseau pour l'entreprise GSB dans le laboratoire de notre établissement scolaire. L'objectif

principal était d'assurer une haute disponibilité et un équilibrage de charge des services web critiques

hébergés dans la DMZ (Demilitarized Zone) de l'entreprise.

Objectifs du Projet

-

Assurer la Haute Disponibilité :

Mettre en place une solution qui garantit que les services restent accessibles même en cas de panne d'un

serveur.

-

Équilibrage de Charge :

Répartir le trafic de manière efficace entre plusieurs serveurs pour améliorer les performances et éviter

la surcharge d'un seul serveur.

-

Sécurité :

Isoler les services critiques dans la DMZ tout en assurant une redondance réseau fiable.

Contraintes

La DSI a établi les contraintes suivantes concernant la mise en place d'une haute disponibilité du serveur

outlab :

- Le serveur, situé dans la DMZ, doit être accessible depuis internet et depuis l'entreprise.

- La solution retenue doit être capable d'évoluer facilement pour répondre à une augmentation des besoins

d'accès concurrents.

- La haute disponibilité du serveur web doit être garantie.

- La synchronisation des données entre les serveurs doit être transparente.

- Les serveurs nécessaires à la mise en place de la solution seront hébergés sur la ferme Nutanix.

Voici le cahier des charges qui m'a suivie lors de la réalisation de ce projet :

Cahier des charges projet

Technologies Utilisées

-

Keepalived :

Pour la gestion de la haute disponibilité et de l'équilibrage de charge via VRRP.

-

Linux (Debian 12) :

Systèmes d'exploitation des serveurs hébergeant les services web.

-

Apache :

Serveurs web pour héberger les applications de GSB.

-

Nutanix :

Pour la virtualisation des serveurs dans le laboratoire.

Architecture de la Solution

-

Infrastructure de la DMZ :

- Trois serveurs web dans la DMZ : OUTLAB1, OUTLAB2, et OUTLAB_SORRY.

- Deux nouvelles machines Debian pour servir de directeurs aux serveurs web.

- Deux réseaux distincts dans la DMZ : 172.31.3.X pour les directeurs et 172.16.3.X pour les serveurs

WEB.

- Un serveur de base de données sécurisé par des pare-feu.

- Keepalived est installé sur les serveurs web pour gérer le VRRP.

-

Fonctionnement de Keepalived :

-

VRRP (Virtual Router Redundancy Protocol) :

Utilisé pour la redondance des adresses IP virtuelles.

-

Configuration de Priorité :

Un serveur est configuré comme MASTER et l'autre comme BACKUP.

-

Failover Automatique :

En cas de défaillance du serveur MASTER, le serveur BACKUP prend automatiquement le relais.

Configuration de Keepalived

Exemple de Configuration sur le Serveur MASTER:

global_defs {

router_id LVS-Directeur-Master

}

vrrp_instance OUTLAB-SERV {

state MASTER

interface ens3

lvs_sync_daemon_interface ens3

virtual_router_id 11

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass OUTLAB

}

virtual_ipaddress {

172.16.6.25

}

}

vrrp_instance OUTLAB-CLI {

state MASTER

interface ens4

lvs_sync_daemon_interface ens4

virtual_router_id 12

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass OUTLAB

}

virtual_ipaddress {

172.31.6.35

}

}

vrrp_sync_group VRRP_sync {

group {

OUTLAB-SERV

OUTLAB-CLI

}

}

virtual_server 172.31.6.35 80 {

delay_loop 30

lb_algo rr

lb_kind NAT

persistance_timeout 300

protocol TCP

real_server 172.16.6.10 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

}

}

real_server 172.16.6.11 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

}

}

}

Exemple de Configuration sur le Serveur BACKUP:

global_defs {

router_id LVS-Directeur-Backup

}

vrrp_instance OUTLAB-SERV {

state BACKUP

interface ens3

lvs_sync_daemon_interface ens3

virtual_router_id 11

priority 50

advert_int 1

authentication {

auth_type PASS

auth_pass OUTLAB

}

virtual_ipaddress {

172.16.6.25

}

}

vrrp_instance OUTLAB-CLI {

state BACKUP

interface ens4

lvs_sync_daemon_interface ens4

virtual_router_id 12

priority 50

advert_int 1

authentication {

auth_type PASS

auth_pass OUTLAB

}

virtual_ipaddress {

172.31.6.35

}

}

vrrp_sync_group VRRP_sync {

group {

OUTLAB-SERV

OUTLAB-CLI

}

}

virtual_server 172.31.6.35 80 {

delay_loop 30

lb_algo rr

lb_kind NAT

persistance_timeout 300

protocol TCP

real_server 172.16.6.10 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

}

}

real_server 172.16.6.11 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

}

}

}

Étapes de Réalisation

-

Étude de cas :

Analyse des besoins de l'entreprise GSB et identification des services critiques.

-

Design de l'architecture :

Conception de l'architecture réseau incluant la DMZ et les serveurs nécessaires.

-

Installation des serveurs :

Mise en place des serveurs web et de base de données dans l'environnement de laboratoire.

-

Configuration de Keepalived :

Installation et configuration de Keepalived sur les serveurs web.

-

Tests de fonctionnalité :

Simulation de pannes pour tester le basculement automatique et la répartition de charge.

-

Documentation :

Rédaction de la documentation technique et des procédures de maintenance.

Résultats

-

Haute Disponibilité :

Les services web de GSB restent accessibles en tout temps grâce à la redondance assurée par Keepalived.

-

Équilibrage de charge :

Amélioration des performances des services web avec une répartition efficace du trafic.

-

Sécurité renforcée :

Les services critiques sont isolés dans la DMZ, minimisant les risques de sécurité tout en assurant leur

disponibilité.

Conclusion

Le projet a démontré l'efficacité de Keepalived pour la gestion de la haute disponibilité et de

l'équilibrage de charge dans une infrastructure réseau d'entreprise. Les compétences acquises lors de ce

projet incluent la configuration et la gestion de réseaux complexes, la mise en place de solutions de haute

disponibilité, et l'importance de la planification et des tests rigoureux pour assurer une infrastructure

robuste et fiable.

Back

GLPI

Définition du Besoin

Afin de faciliter la gestion de l'ensemble des ordinateurs, l'entreprise GSB a décidé de mettre en place

la solution GLPI (Gestionnaire Libre de Parc Informatique). GLPI est une application open source

permettant de gérer toutes les problématiques de gestion de parc informatique, depuis l'inventaire des

composants matériels et logiciels jusqu'à l'assistance aux utilisateurs.

- Deux employés de GSB, Viviane NOEL (vnoel) et Jean CARADEC (jcaradec), simuleront des déclarations

d’incidents. Viviane NOEL utilise un poste client Linux, tandis que Jean CARADEC travaille sur un poste

client Windows.

- Deux autres employés, tech1 et tech2, simuleront la gestion des incidents déclarés par les

utilisateurs.

Contraintes

- Le serveur INVENTLAB est situé dans le VLAN "Serveurs". Il possède l'adresse IP 192.168.250.30 et

fonctionne sous Linux Debian.

- Les postes des employés de l'entreprise fonctionnent sous Windows 10 et Linux Debian 12.

Cahier des charges projet

Mise en Place de l'Application GLPI

Nous avons mis en place l’application GLPI pour permettre la remontée d’inventaire, offrant ainsi une vue

globale des machines du parc informatique et facilitant la gestion de ce parc.

Paquets Nécessaires

-

Serveur: apache2, mariadb-server, mariadb-client, php, build-essential, perl,

libapache2-mod-perl2, libxml-simple-perl, libio-compress-perl, libdbi-perl, libapache-dbi-perl,

libdbd-mysql-perl, libnet-ip-perl, libsoap-lite-perl, libxml-libxml-perl

-

Modules PHP: php-mysql, php-gd, php-mbstring, php-ldap, php-imap, php-apcu, php-xmlrpc,

php-soap, php-cas, php-xml, php-intl, php-zip, php-bz2

-

Clients: fusioninventory-agent (Linux),

fusioninventory-agentwindows-x642.6.exe (Windows)

Configuration de la Base de Données

Après avoir installé tous les paquets nécessaires sur le serveur, nous avons configuré la base de données

pour GLPI :

- Sécurisation de MySQL :

mysql_secure_installation

mysql

- Création de l'utilisateur pour GLPI :

create user 'glpiuser'@'localhost' identified by 'Admin1*';

- Création de la base de données GLPI :

create database glpi;

- Attribution des droits :

grant all privileges on glpi.* to 'glpiuser'@'localhost';

flush privileges;

Installation de GLPI

- Suppression du fichier de base d’Apache :

rm /var/www/html/index.html

- Téléchargement et installation de GLPI :

cd /var/www/html

wget https://github.com/glpi-project/glpi/releases/download/10.0.6/glpi-10.0.6.tgz

tar -zxvf glpi-10.0.6.tgz

rm glpi-10.0.6.tgz

- Modification du VirtualHost :

nano /etc/apache2/sites-available/000-default.conf

Ajouter :

DocumentRoot /var/www/html/glpi

- Attribution des droits utilisateurs :

chown www-data:www-data /var/www/html/glpi -R

- Activation du mod_rewrite :

a2enmod rewrite

service apache2 restart

Configuration du Plugin FusionInventory

Pour remonter l’inventaire avec GLPI, nous utilisons le plugin FusionInventory :

- Téléchargement du plugin :

wget https://github.com/fusioninventory/fusioninventory-for-glpi/releases/download/glpi10.0.6+1.1/fusioninventory-10.0.6+1.1.tar.bz2

tar xvf fusioninventory-10.0.6+1.1.tar.bz2 -C /var/www/html/glpi/plugins/

- Activation du plugin dans l’interface GLPI et configuration du cron :

crontab -e

Ajouter :

* * * * * cd /var/www/html/glpi/front/ && /usr/bin/php cron.php &>/dev/null

Configuration des Clients

-

Linux :

- Installation et configuration de FusionInventory

:

bash apt-get install fusioninventory-agent nano /etc/fusioninventory/agent.cfg Ajouter

: config server=http://192.168.250.30/plugins/fusioninventory/ Redémarrer le

service : bash systemctl restart fusioninventory-agent.service fusioninventory-agent

-

Windows :

- Installation de FusionInventory

:

plaintext fusioninventory-agent_windows-x64_2.6.exe Spécifier

: url http://192.168.250.30/plugins/fusioninventory/ Démarrer l'application

: bash fusioninventory-agent

Avec cette configuration, GLPI permet une gestion centralisée et efficace du parc informatique de

l’entreprise GSB.

Back

Cryhod

Contexte

Suite à l’épidémie de COVID survenue entre 2019 à 2021, le télétravail a pris une place importante de

l’environnement de travail des utilisateurs de la CNPF, en effet le remplacement au fur et à mesure des

ordinateurs fixes par des ordinateurs portables a vu le jour.

Un nouveau concept dans l’administration des postes de la CNPF a donc dû être décidé. La DSI (Direction des

Systèmes d’Information) a donc choisi de mettre en place une solution de cryptage des disques et des données

personnelles des utilisateurs nomades ainsi que de leurs outils de travail numérique pour répondre au risque

de cybercriminalité.

Objectif

Les objectifs derrière cette administration et sécurisation des ordinateurs portables de la société est de

protéger les données à caractère personnel et professionnel des utilisateurs tout en respectant les règles

imposées par le

RGPD.

Le

Règlement

Général sur la

Protection des

Données encadre le traitement des données personnelles sur le territoire de l'Union

européenne.

Pourquoi CRYHOD

CRYHOD est une solution développée par PRIM’X qui permet de crypter des disques et qui a obtenu des labels

et certifications pour sa solution.

- Visa de sécurité ANSSI

- Certification CC EAL3+

- Qualification niveau standard par l’ANSSI

- Diffusion restreinte OTAN et UE restreinte

CRYHOD est un logiciel de chiffrement moderne qui assure le chiffrement complet des disques durs des postes

de travail portables de l’entreprise.

Avec CRYHOD, l’accès aux données n’est possible que pour les utilisateurs autorisés et dûment authentifiés

au pré-bout.

Prise en main

Documentation

Le logiciel CRYHOD dispose d’un guide d’utilisation pour comprendre les fonctionnalités et la mise en place

du logiciel à travers les politiques qui définissent les règles applicables à celui-ci. Ces règles sont

nommées par le terme « politique » suivi d’un nombre pour les différencier. Il existe plusieurs

catégories qui définissent l’usage des politiques et les regroupent.

- Type d’accès

- Organisation-Déploiement

- Gestion des mots de passe

- Contrôle des certificats

- Interfaces utilisateurs

- Avancé-Détails

Certaines d’entre elles sont dans la racine même de la gestion des politiques cas elles sont plus générales

que les autres quant à leur fonction.

Banque de connaissance

PRIM’X met à disposition sur leur site internet des cas pratiques de l’utilisation et le paramétrage de

CRYHOD. Cette banque de connaissance permet l’accès à des articles qui précisent et montrent les

potentielles difficultés qui peuvent être rencontrées. D’autres articles expliquent même des schémas de

déploiement de la solution ainsi que des solutions de résolution en cas d’erreur de configuration pour les

cas les plus communs.

Choix de la stratégie d’utilisation

En termes de déploiement CRYHOD propose une solution pour être mixé avec un Active Directory tout en

déployant ses politiques grâce à des GPO (Stratégie de groupe). Cette pratique permet de centraliser via

l’annuaire Active Directory les politiques pour gérer CRYHOD.

La CNPF n’utilisant pas d’Active Directory comme système de gestion des utilisateurs sur les postes une

autre méthode est donc à prioriser. Après recherche, il existe une méthode alternative pour centraliser les

politiques et autres données utilisées par CRYHOD. Il suffit simplement de centraliser ses données sur un

accès sécurisé et de donner comme indication à CRYHOD l’adresse UNC du poste qui tient pour rôle le stockage

des données sur des répertoires partagés.

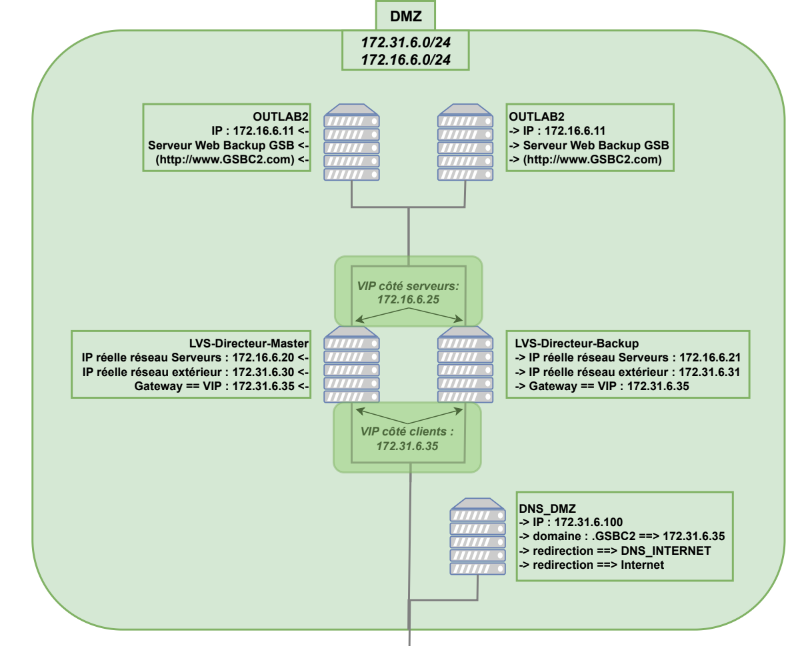

Mise en place

Phase de test

Lors de prise en main du logiciel à travers la compréhension des documentations ainsi que de l’approche pas

à pas du logiciel, il est vite possible de comprendre la structure principale que CRYHOD demande pour bien

fonctionner. Tout d’abord, dans le cas des politiques dites alternatives, il faut savoir que la gestion des

informations doit s’effectuer depuis des dossiers partagés sur le réseau pour rendre accessibles les

fichiers de configuration et de connexion aux utilisateurs de manière centralisée.

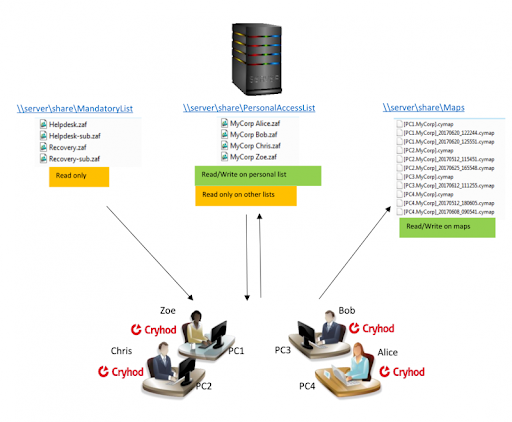

Crédits-Photos : CRYHOD © Prim’X Technologies

Dans le plan de configuration précédent on peut visualiser la configuration attendue pour la CNPF, en effet

cette configuration permet de centraliser les comptes utilisateurs. Une question peut alors se poser quant à

l’accès de l'ordinateur si le serveur n’est pas accessible.

CRYHOD se compose d’une mémoire cache qui peut donc être utilisée si le serveur n’est pas accessible sur

moment lors d’une tentative de connexion, lorsque une connexion est établie avec le serveur les informations

stockées dans le cache de la machine vont alors être mise à jour de manière automatique.

Il est important de préciser que les accès obligatoires des comptes administrateur peuvent être inclus dans

le client d’installation afin d’assurer un accès perpétuel à la machine.

L’avantage notable de centraliser les fichiers d’accès est dans l’aspect dépannage du logiciel car cela

permet pour la génération des mots de passe temporaire d’avoir sous la main les fichiers images des disques

pour le faire. Cette méthode permet d’éviter de bloquer un ordinateur portable qui ne peut avoir une

maintenance physique pour le débloquer.

Production

L’idée pour la mise en production du produit CRYHOD est de l’associer au « Microsoft Deployment

Toolkit » qui sert pour la mise en service des ordinateurs portables de la CNPF afin de crypter via un

installateur en « .msi » les disques. Les politiques près faites seront alors maîtrisées dans

l’installateur pour que l’ordinateur connaisse l’emplacement des répertoires centralisés qu’il va devoir

utiliser.

Ce système d’administration permet un avantage considérable pour du dépannage en cas de perte de mot de

passe de la part d’un utilisateur car une maintenance à distance est possible grâce à la centralisation des

images des disques qui est l’élément principal lors d’un dépannage suite à la perte d’un mot de passe. Pour

préciser mon propos, lors d’un dépannage l’image cryptée du disque de l’ordinateur permet de générer un

accès temporaire à l’ordinateur et cela à distance. Une procédure qui ne serait pas possible si les images

des disques était contenu uniquement en local, une maintenance physique serait alors obligatoire pour le

déverrouillage d’un poste.

La centralisation des accès obligatoires des comptes administrateurs permet en cas de changements du mot de

passe pour des questions de sécurité une mise à jour automatique sur tous les postes centralisés avec le

serveur qui stocke les données.

Voici une documentation sur CRYHOD et ça mise en place dans l'entreprise :

Documentation CRYHOD

Back

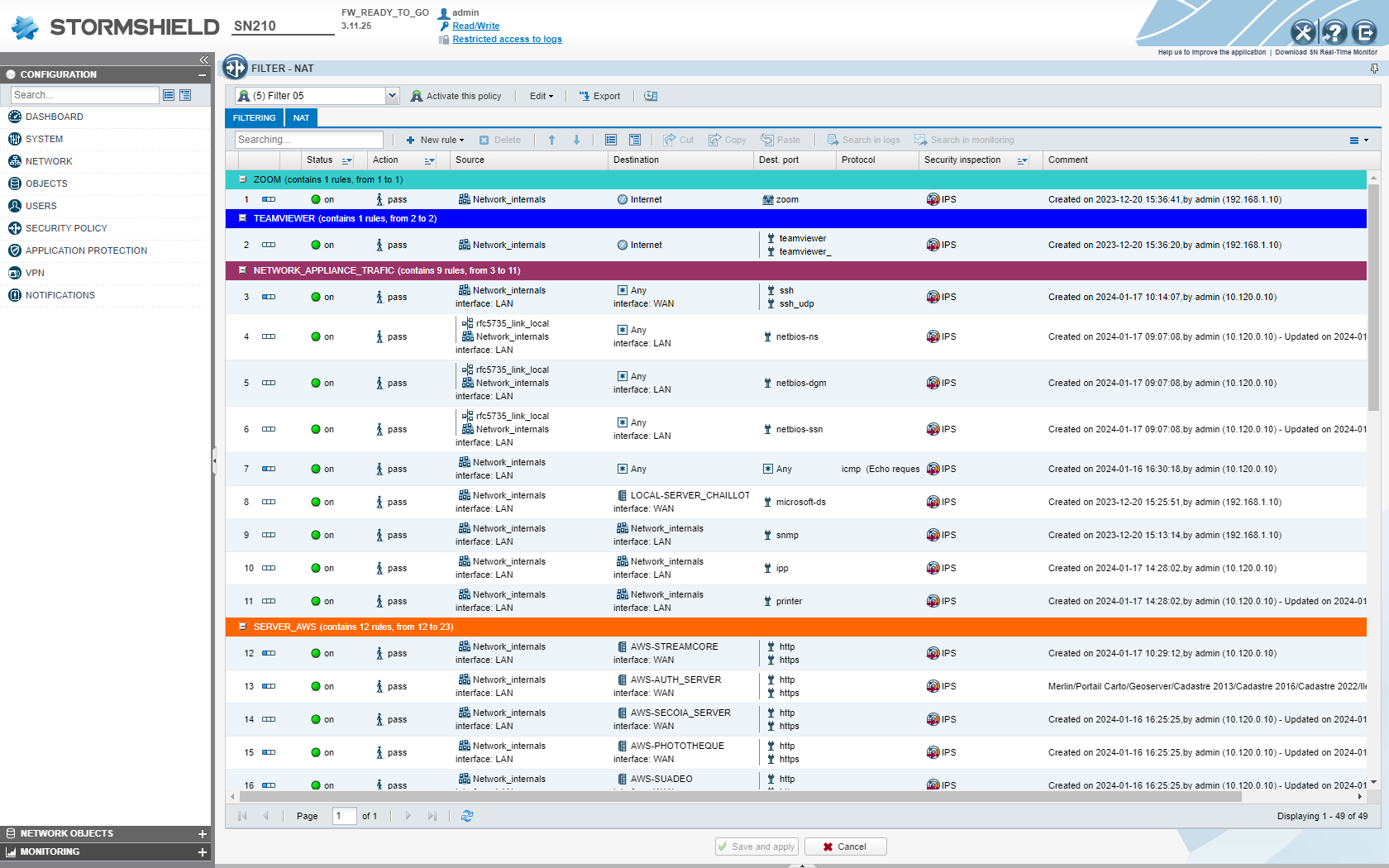

Stromshield

Introduction

Pendant ma formation BTS SIO en spécialisation SISR au lycée Benjamin Franklin à Orléans, j'ai effectué

deux stages obligatoires de six à sept semaines chacun. Ce rapport se concentre sur mon deuxième stage

au CNPF, sous la supervision de M. Alain Posty et M. Sylvain Guichard. Ma mission principale était de

mettre en place un système de filtrage sur les pare-feu Stormshield pour une centaine de sites en

France, suite à la centralisation des CRPF en CNPF.

Présentation générale

Présentation de l’entreprise

CNPF (Centre National de la Propriété Forestière)

Le CNPF est un établissement public sous la tutelle du Ministère de l'Agriculture, chargé de la gestion

durable des forêts privées, représentant environ 23% du territoire français. Il regroupe et conseille

les propriétaires forestiers, et oriente la gestion de leurs propriétés. Le CNPF est réparti en une

centaine de sites à travers la France, structurés autour de 11 CRPF, avec un service R&D et plus de

500 agents.

SDN (Service du Développement Numérique)

Le SDN, dirigé par M. Alain Posty, gère l'infrastructure informatique du CNPF. Situé principalement à

Orléans, le SDN comprend des administrateurs systèmes, développeurs, techniciens support et chefs de

projet. Sa mission est d’organiser, développer et sécuriser les systèmes d’information du CNPF.

Présentation de la mission

Lors de mon stage, j'étais chargé de concevoir et de mettre en place des règles de filtrage sur les

pare-feu Stormshield, et de catégoriser les outils de gestion de la sécurité sur l’infrastructure Cloud

AWS du CNPF. Cette mission visait à renforcer la cybersécurité du CNPF face aux menaces croissantes.

Contexte

Depuis la centralisation des réseaux du CNPF, les pare-feu Stormshield n'avaient que des configurations

de base permettant l’interconnexion via un VPN dans un MPLS. Il n’y avait aucune règle de filtrage.

Objectifs

L'objectif était de limiter les flux et de contrôler l'accès des utilisateurs au réseau local et à

Internet pour prévenir les intrusions et limiter leur propagation.

Mise en œuvre

Les outils utilisés incluaient Streamcore, Stormshield (SNS210 et SMC), Nmap et AWS. J'ai analysé les

protocoles les plus utilisés par les utilisateurs sur une dizaine de sites et étudié les destinations

des flux pour bloquer les accès non essentiels.

Théorie et Pratique

J'ai développé un tableau de règles de filtrage et proposé l’utilisation d'un proxy pour filtrer les

sites Internet jugés dangereux ou inappropriés. Cette solution vise à équilibrer sécurité et

accessibilité, tout en sensibilisant les utilisateurs aux risques liés à la navigation Internet.

Proposition

Pour optimiser la sécurité, il est recommandé de mettre en place un proxy pour filtrer les sites

potentiellement dangereux. Cela protégera l’infrastructure du CNPF et encouragera des pratiques

responsables en ligne.

Conclusion

Cette expérience de stage a été enrichissante et m'a permis d’acquérir de nouvelles compétences en

cybersécurité et en gestion des réseaux. Elle a également clarifié mes aspirations professionnelles

futures.

Voici un rapport sur Stormshield et mon approche de la création des règles de filtrage et leur mise en place

dans l'entreprise :

Rapport Stormshield

Back

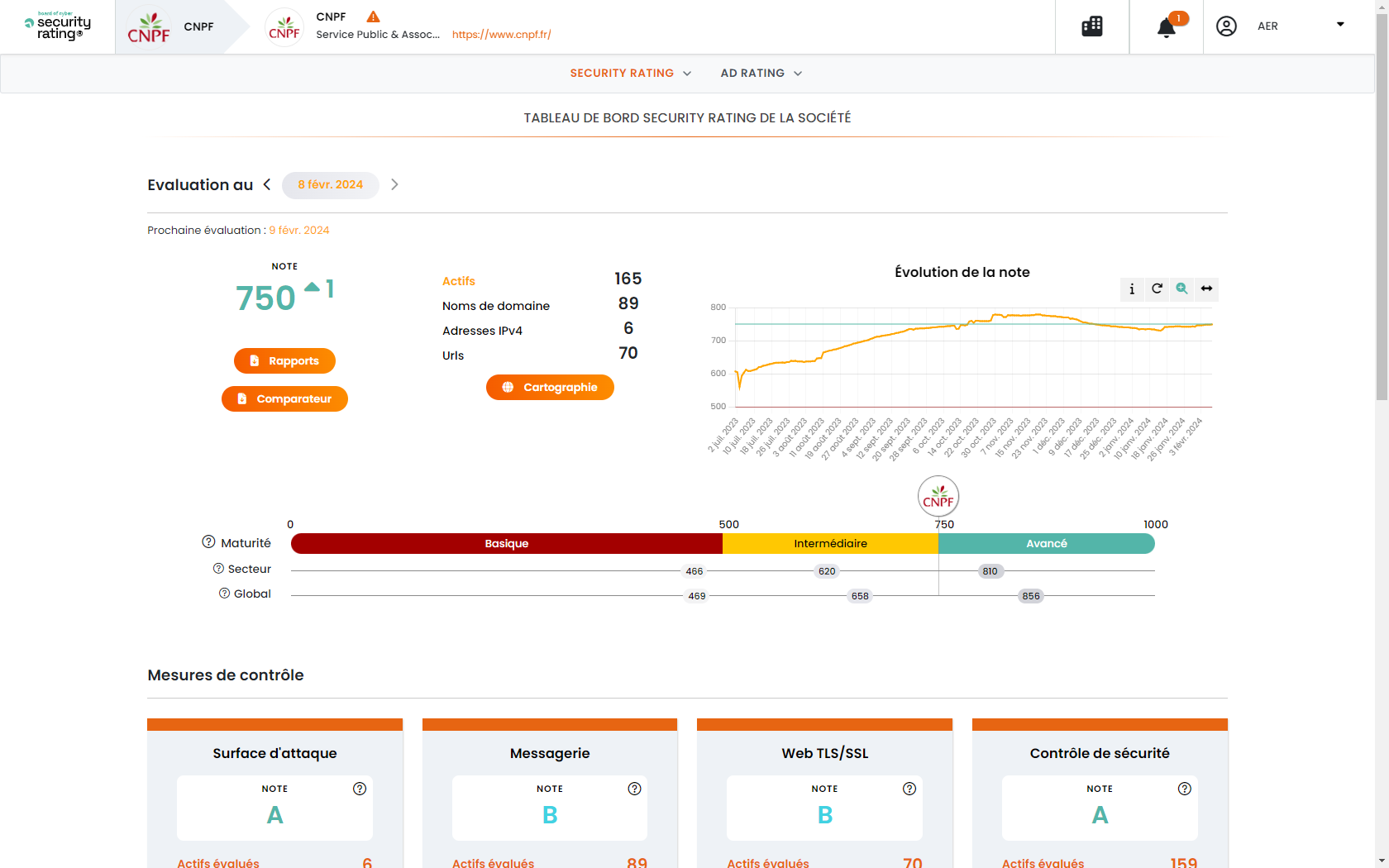

Board of Cyber

Présentation de l'Outil Board of Cyber SEO et Mon Expérience de Stage au CNPF

Introduction

Lors de ma deuxième année de BTS SIO (Services Informatiques aux Organisations) avec une spécialisation

en SISR (Solutions d'Infrastructure Système et Réseau), j'ai effectué un stage au Centre National de la

Propriété Forestière (CNPF). Pendant ce stage, j'ai découvert et travaillé avec l'outil Board of Cyber

SEO, une solution avancée pour la gestion et la surveillance de la sécurité informatique.

Fonctionnalités Clés de Board of Cyber SEO

1. Surveillance Continue:

- Détection des menaces en temps réel et alertes instantanées.

2. Gestion des Vulnérabilités:

- Scans réguliers et rapports détaillés avec recommandations.

3. Tableau de Bord Personnalisable:

- Visualisation des données de sécurité et KPIs.

4. Gestion des Incidents:

- Journal et analyse post-incident pour améliorer la défense.

5. Conformité Réglementaire:

- Audits et rapports de conformité pour régulations comme GDPR.

6. Gestion des Périphériques et des Utilisateurs:

- Contrôle d'accès et surveillance des périphériques.

Mon Expérience au CNPF avec Board of Cyber SEO

Durant mon stage au CNPF, j'ai travaillé sur la sécurisation du réseau sur une centaine de sites en

France. Board of Cyber SEO a été essentiel pour :

-

Surveillance Proactive: Identification et neutralisation des accès non autorisés.

-

Gestion des Vulnérabilités: Détection rapide des failles et application des

correctifs.

-

Tableau de Bord Efficace: Vue d'ensemble claire pour des décisions rapides.

-

Gestion des Incidents: Documentation et compréhension approfondies des incidents.

-

Conformité Réglementaire: Simplification des processus de conformité.

Avantages pour le CNPF

-

Proactivité et Réactivité: Amélioration de la posture de sécurité.

-

Réduction des Risques: Diminution des risques de cyberattaques.

-

Efficacité: Gestion centralisée et rapports détaillés.

-

Visibilité Améliorée: Meilleure gestion de l'infrastructure informatique.

Conclusion

Mon expérience avec Board of Cyber SEO au CNPF a été très enrichissante. Cet outil a grandement

amélioré la sécurité informatique de l'organisation et m'a permis d'acquérir des compétences précieuses

en matière de sécurité informatique.

Back

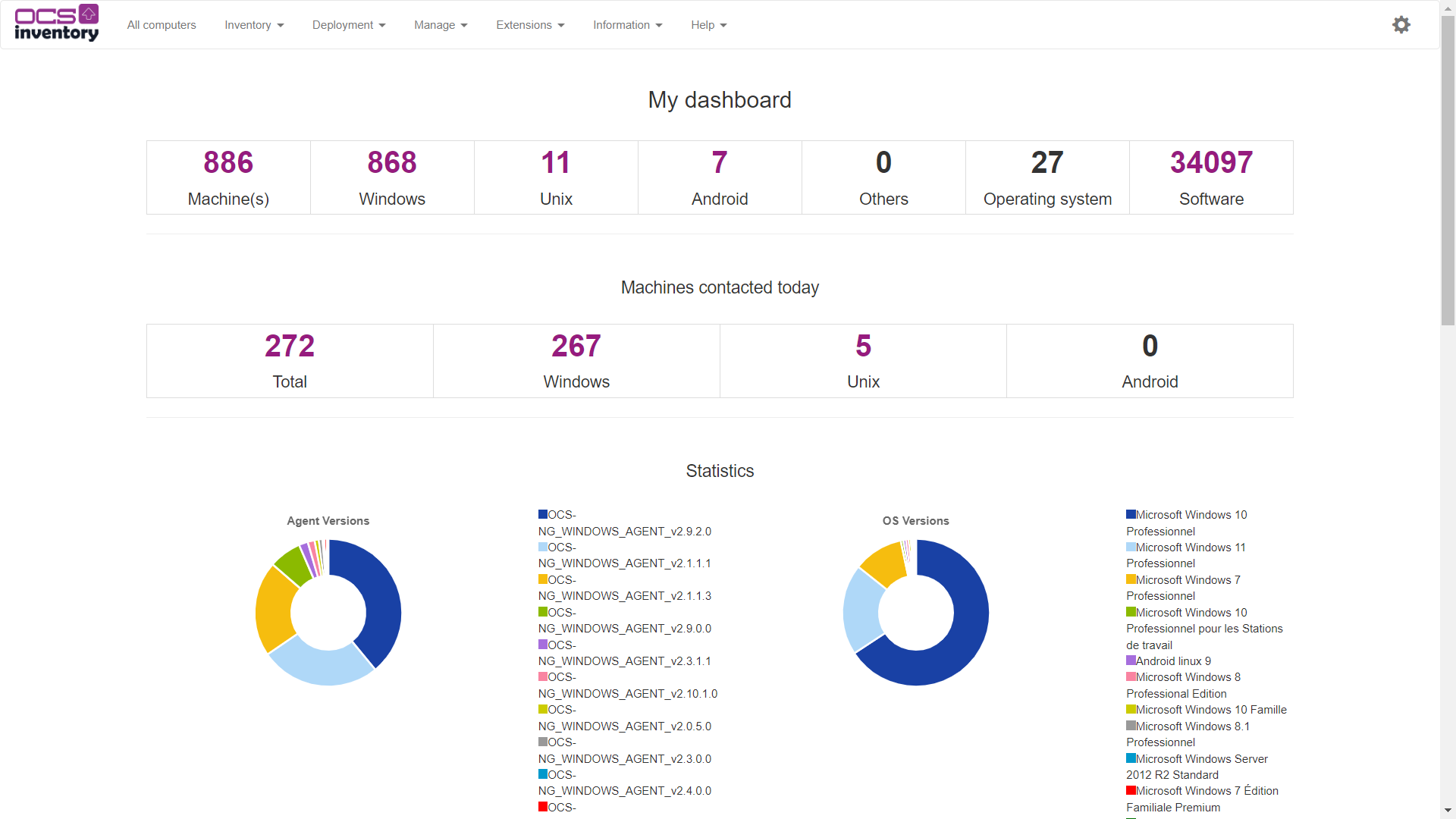

OCS Inventory

Présentation de l'Outil OCS Inventory et Mon Expérience de Stage au CNPF

Introduction

Lors de ma deuxième année de BTS SIO (Services Informatiques aux Organisations) avec une spécialisation

en SISR (Solutions d'Infrastructure Système et Réseau), j'ai effectué un stage au Centre National de la

Propriété Forestière (CNPF). Pendant ce stage, j'ai découvert et travaillé avec l'outil OCS Inventory,

une solution puissante pour la gestion et l'inventaire des actifs informatiques.

Fonctionnalités Clés de OCS Inventory

-

Inventaire Automatisé:

- Découverte et documentation automatique des matériels et logiciels sur le réseau.

-

Gestion des Actifs:

- Suivi des matériels, logiciels, et licences en temps réel.

-

Déploiement de Logiciels:

- Distribution centralisée de logiciels et mises à jour.

-

Surveillance du Réseau:

- Monitoring continu des équipements connectés.

-

Rapports Personnalisés:

- Génération de rapports détaillés pour l’analyse et la prise de décision.

-

Intégration avec GLPI:

- Connexion avec le logiciel de gestion des services IT pour une gestion complète.

Mon Expérience au CNPF avec OCS Inventory

Durant mon stage au CNPF, j'ai travaillé sur l'amélioration de la gestion des actifs informatiques

répartis sur une centaine de sites en France. OCS Inventory a été essentiel pour :

-

Inventaire Exhaustif: Recensement complet et précis des équipements matériels et

logiciels.

-

Gestion Efficace des Actifs: Suivi en temps réel des modifications et des mises à

jour.

-

Déploiement Centralisé: Distribution de logiciels et correctifs de sécurité de

manière uniforme sur tous les sites.

-

Surveillance Proactive: Détection des nouvelles machines et des changements de

configuration.

-

Rapports Détaillés: Production de rapports pour aider à la prise de décisions

stratégiques.

Avantages pour le CNPF

-

Visibilité et Contrôle: Amélioration de la gestion des actifs avec une visibilité

accrue.

-

Efficacité et Rapidité: Simplification du déploiement de logiciels et des mises à

jour.

-

Proactivité: Surveillance continue pour une meilleure anticipation des besoins et des

problèmes.

-

Complémentarité: Intégration avec GLPI pour une gestion globale et harmonisée des

services IT.

Conclusion

Mon expérience avec OCS Inventory au CNPF a été extrêmement enrichissante. Cet outil a considérablement

amélioré la gestion des actifs informatiques de l'organisation et m'a permis d'acquérir des compétences

précieuses en gestion et en sécurité des systèmes d'information.

9 items, select a project